El auge de los principios en la IA

En un post anterior explicamos los beneficios y las oportunidades de negocio de la inteligencia artificial (IA) y el big data, y al final también insinuamos algunas posibles consecuencias negativas. De hecho, con la creciente incorporación de la IA se está prestando más atención a las posibles consecuencias negativas y no deseadas que pueda tener. Esto ha llevado a la proliferación de directrices éticas voluntarias o Principios de la IA mediante los cuales las organizaciones declaran públicamente que quieren utilizar la IA de forma justa, transparente, segura, sólida, centrada en el ser humano, etc., evitando cualquier consecuencia negativa o daño.

La Universidad de Harvard ha analizado los Principios de la IA de las primeras 36 organizaciones del mundo que publicaron este tipo de directrices e identificó nueve categorías como las más utilizadas, entre las que se encuentran los valores humanos, la responsabilidad profesional, el control humano, la equidad y la no discriminación, la transparencia y la explicabilidad, la seguridad y la protección, la responsabilidad, la privacidad y los derechos humanos. La organización sin ánimo de lucro Algorithm Watch mantiene un inventario abierto de Directrices de IA que cuenta actualmente con más de 160 organizaciones. Otros ejemplos de posibles consecuencias imprevistas del uso de la IA incluyen el futuro del trabajo, los robots asesinos, la relación entre las personas y los robots, las implicaciones en materia de responsabilidad, la superconcentración de datos, poder y riqueza con el consiguiente aumento de la desigualdad, las noticias falsas, etc. Para cada uno de esos riesgos se han definido principios con el objetivo de evitar esos impactos negativos.

El problema para las organizaciones que utilizan la IA de forma sistemática no es tanto reconocer que necesitan principios de IA, sino identificar qué principios adoptar y cómo aplicarlos en sus organizaciones para que no se queden en declaraciones vacías y se implementen de forma práctica.

Cómo seleccionar los principios de IA adecuados para su organización Como hemos visto, hay un gran número de principios entre los que elegir y, por este motivo, no resulta fácil identificar los más convenientes para su organización. Vamos a ver tres directrices que ayudan a las organizaciones a elegir los principios más adecuados.

Directriz núm. 1: el sector

En función del sector al que pertenezca una organización existirán algunos riesgos especialmente importantes de evitar. Por ejemplo, en el sector industrial, donde se utilizan robots inteligentes, es importante evitar los riesgos relacionados con la seguridad física. En el sector sanitario, cuando los médicos hacen uso de la IA para diagnosticar un cáncer, no se recomiendan algoritmos opacos (de caja negra) ya que los médicos necesitan entender por qué un sistema de IA sugiere que una determinada imagen de rayos X proporciona pruebas de un cáncer. Lo mismo ocurre en el sector público, donde el acceso a los servicios públicos debe hacerse de forma transparente. En el sector de las finanzas y los seguros es ilegal discriminar a los llamados grupos vulnerables, por lo que es importante evitar los riesgos relacionados con la parcialidad.

Directriz núm. 2: elija los principios de la IA que sean viables para su organización

Si usted es una empresa, algunos retos de la IA están fuera de su alcance y resulta complicado hacerlos frente. Por ejemplo, como empresa individual es difícil actuar ante el reto del "futuro del trabajo" o el de la "responsabilidad" (¿quién es responsable de las acciones de los sistemas de IA que siguen aprendiendo de forma autónoma a partir de los datos una vez lanzados al mercado?). Estos retos son competencia de las administraciones públicas y las organizaciones individuales tienen una influencia limitada sobre ellos. Sin embargo, otros retos recaen dentro del ámbito de las organizaciones individuales, como garantizar la privacidad, la equidad, la explicabilidad, la seguridad, etc.

La siguiente imagen ofrece ejemplos de los principios de la IA que recaen en el ámbito de las organizaciones individuales frente a los que son responsabilidad de las administraciones públicas.

Directriz núm. 3: principios específicos de la IA frente a principios genéricos de la IA

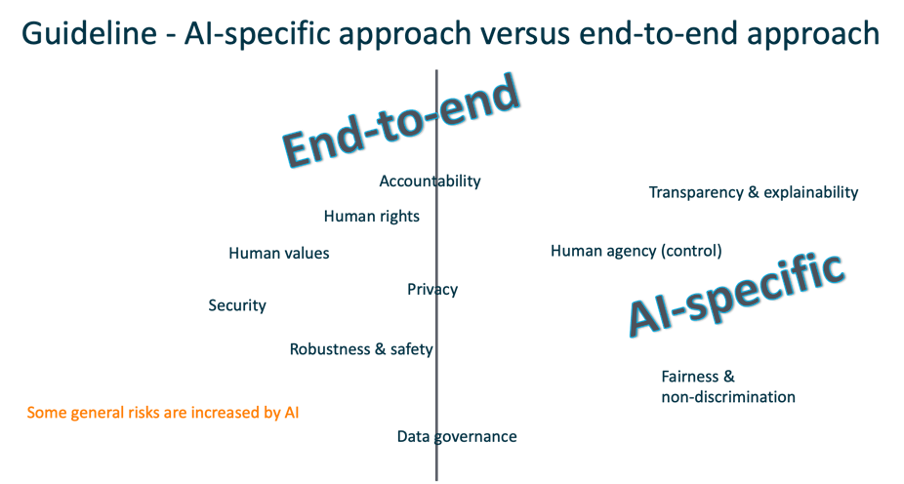

Algunos retos del uso de la IA son específicos de la IA en el sentido en que no se dan en otros sistemas digitales. Nos referimos a la explicabilidad, la equidad y la autonomía. Otros retos son genéricos, es decir, son relevantes para cualquier sistema digital. Por ejemplo: la privacidad, la seguridad y la protección.

Por lo tanto, las organizaciones deben decidir si quieren abarcar todos los riesgos posibles que implica el uso de los sistemas de IA (enfoque integral) o si quieren limitarse a los riesgos específicamente relacionados con la IA (enfoque específico de la IA). No es que un enfoque sea mejor que el otro, sino que está más relacionado con el hecho de que una organización ya esté gestionando todos los riesgos genéricos mediante procesos estándar. En este caso podrían centrar sus principios de IA solo en los retos específicos de la IA. Las organizaciones que aún no tienen controlados los riesgos genéricos o que quieren poner un énfasis específico en la IA responsable podrían optar por el enfoque integral. Los dos enfoques se ilustran en la siguiente imagen. Obsérvese que algunos de los riesgos genéricos pueden ser más importantes en el contexto de la IA. Por ejemplo, la privacidad y la protección de datos es siempre un riesgo que las empresas deben gestionar, pero dado que muchas técnicas de IA utilizan datos personales, este riesgo adquiere mayor importancia.

Cómo aplicar los principios de la IA en su organización

Una vez que una organización ha decidido qué principios adoptar, el siguiente paso es implementarlos como un proceso empresarial, junto con los demás procesos ya existentes, como los relacionados con la privacidad o la seguridad. Aparte de los principios de la IA, hay otros cuatro elementos que ayudan a aplicar los principios: formación y concienciación, cuestionarios, herramientas y un modelo de gobernanza.

- La formación y la concienciación pueden lograrse mediante cursos en línea sobre la ética de la IA y con talleres con unidades de negocio específicas que utilicen inteligencia artificial.

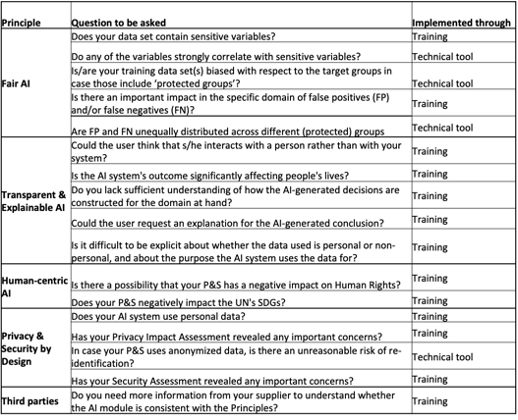

- Los cuestionarios ayudan a los empleados a pensar en las preguntas correctas y ofrecen recomendaciones cuando las respuestas iniciales necesitan de más aclaraciones. Algunas de esas preguntas pueden responderse mediante sesiones de formación, mientras que otras requieren herramientas técnicas. La siguiente imagen muestra el cuestionario del método Responsible AI by Design.

- Mientras que los principios relacionados con la autonomía del sistema de IA pueden explicarse mediante sesiones de formación, otros principios, como los relacionados con el sesgo de los datos y la explicabilidad, requieren herramientas técnicas.

- Por último, un modelo de gobernanza define las funciones y responsabilidades de las partes interesadas en el proceso, junto con un protocolo de jerarquía en caso de que surjan dudas sobre determinados riesgos.

¿Qué relación guarda esto con el nuevo Reglamento de la UE?

Los principios de la IA son directrices voluntarias que las empresas (y otras organizaciones) cumplen cuando desarrollan, compran o utilizan sistemas de IA. La aplicación de los principios les "obliga" a pensar en la (gravedad de la) posible influencia sobre las personas y la sociedad y a tomar medidas preventivas o mitigadoras en caso de que tales riesgos sean significativos.

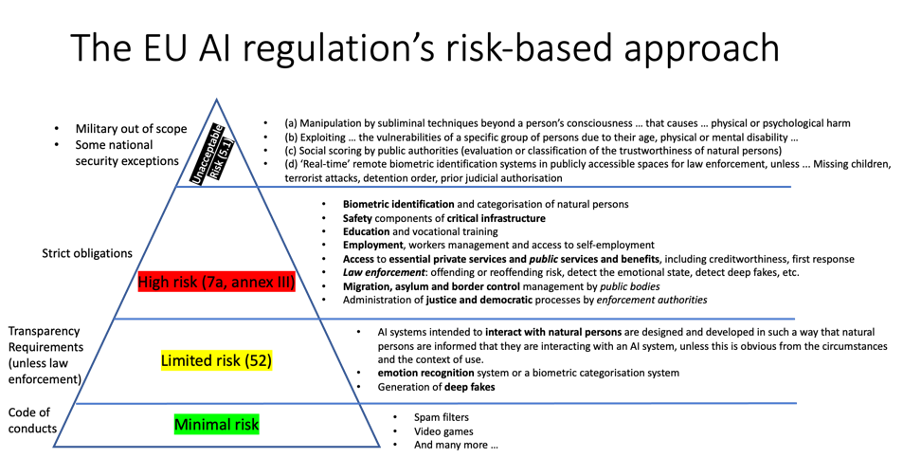

El Reglamento va un paso más allá y exige que, para determinados usos de alto riesgo de la IA, las organizaciones estén obligadas a cumplir normas estrictas antes de la comercialización de un determinado sistema de IA. El Reglamento sobre IA que la Comisión Europea presentó en abril de 2021 identifica cuatro niveles de riesgo: riesgos inaceptables, altos, medios y limitados de los usos de la IA, como se ilustra en la siguiente imagen.

Los usos con riesgo inaceptable están prohibidos. Los usos de la IA con riesgo alto están sujetos a obligaciones estrictas que deben seguir los proveedores y usuarios de la IA (los que la ponen en el mercado) antes de lanzarla al mercado europeo. Estas obligaciones estrictas incluyen un sistema de gestión de riesgos, datos y gobernanza de datos, documentación técnica, mantenimiento de registros (logs), transparencia y suministro de información a los usuarios, supervisión humana, precisión, solidez y ciberseguridad. Los usos de riesgo medio de la IA tienen ciertas obligaciones de transparencia hacia los usuarios finales, como notificar a las personas que están hablando con un chatbot en lugar de con una persona, si existe la posibilidad de confundirlos.

Las organizaciones que ya han adoptado y aplicado los principios de la IA estarán mejor preparadas para el nuevo Reglamento sobre IA, puesto que varias de las acciones y comprobaciones obligatorias ya forman parte de sus procesos empresariales. Además, ya tienen la mentalidad correcta de pensamiento crítico respecto al impacto potencial de los sistemas de IA.

Para las organizaciones que aún no se encuentran en esta fase, no hay que alarmarse, ya que se espera que pasen muchos meses (quizá algunos años) antes de que los Estados miembros y el Parlamento Europeo aprueben el nuevo Reglamento. Y una vez que el Reglamento entre en vigor, todas las organizaciones podrán prepararse y adoptar las medidas necesarias dentro del periodo de gracia de dos años.

El Reglamento se aplicará a cualquier sistema de IA que funcione en el mercado europeo, independientemente de dónde se desarrolle o se implante.